📋 一、准备工作

1. 获取 DeepSeek API 密钥

- 访问 DeepSeek 控制台

- 创建应用 → 获取

API Key - 记录 API 地址(通常为

https://api.deepseek.com)

2. 选择部署方式

| 方式 | 难度 | 适合场景 | 推荐指数 |

|---|---|---|---|

| Vercel | ⭐ | 快速体验/无需服务器 | ★★★★★ |

| Docker | ⭐⭐ | 生产环境/容器化部署 | ★★★★☆ |

| 本地部署 | ⭐⭐ | 开发调试/自定义修改 | ★★★☆☆ |

🚀二、部署ChatGPT-Next-Web

🌐 方案一:Vercel 云端部署(推荐)

步骤 1:一键部署

- 点击官方仓库 ChatGPT-Next-Web 的 "Deploy" 按钮

- 使用 GitHub 账号登录 Vercel

步骤 2:配置环境变量

在 Vercel 部署界面设置:

OPENAI_API_KEY = XXX #输入OPENAI的api (只想用deepseek随便填一个即可)

CODE = your-password-123 # 访问密码

步骤 3:完成部署ChatGPT-Next-Web

- 点击 Deploy 按钮

- 等待 2 分钟自动完成

- 访问生成的域名(如

your-app.vercel.app)

🐳 方案二:Docker 部署

快速启动命令

docker run -d --name chatgpt-web \

-p 3000:3000 \

-e CODE="your-access-code" \

yidadaa/chatgpt-next-web管理容器

# 查看运行状态

docker ps -a | grep chatgpt-web

# 更新版本

docker pull yidadaa/chatgpt-next-web

docker restart chatgpt-web💻 方案三:本地手动部署

1. 克隆仓库

git clone https://github.com/Yidadaa/ChatGPT-Next-Web.git

cd ChatGPT-Next-Web2. 配置环境

创建 .env.local 文件:

CODE=your_secret_code3. 启动服务

npm install && npm run build

npm start访问地址

http://localhost:3000

🌟三、在新版本ChatGPT-Next-Web内设置deepseek模型

1.访问ChatGPT-Next-Web,点击左下角的设置

2.点击自定义接口

3.自定义模型

接口密钥:输入之前获取的deepseek api

4.选择想要的模型

DeepSeek 提供了多个 API 模型,分别是 deepseek-chat、deepseek-coder 和 deepseek-reasoner,它们各自针对不同的应用场景和任务进行优化。以下是它们的区别:

1. DeepSeek-Chat

- 主要用途: 专注于自然语言对话和聊天场景。

- 特点:

- 擅长处理开放域对话、问答、情感分析等任务。

- 能够生成流畅、自然的对话内容。

- 适合用于聊天机器人、客服系统、社交互动等场景。

- 适用场景:

- 用户交互式对话。

- 情感支持和陪伴。

- 信息查询和简单问答。

2. DeepSeek-Coder

- 主要用途: 专注于代码生成、代码理解和编程相关任务。

- 特点:

- 擅长生成代码片段、代码补全、代码注释和代码翻译。

- 支持多种编程语言(如 Python、JavaScript、Java 等)。

- 能够理解代码逻辑并提供优化建议。

- 适用场景:

- 开发者工具中的代码补全和生成。

- 代码审查和优化。

- 编程教学和辅助学习。

3. DeepSeek-Reasoner

- 主要用途: 专注于逻辑推理、数学计算和复杂问题解决。

- 特点:

- 擅长处理需要逻辑推理、数学推导和复杂分析的任务。

- 能够解决数学问题、逻辑谜题和科学计算问题。

- 适合需要深度分析和推理的场景。

- 适用场景:

- 数学问题求解。

- 逻辑推理和谜题解答。

- 科学计算和数据分析。

总结

- DeepSeek-Chat: 适合自然语言对话和聊天场景。

- DeepSeek-Coder: 适合编程和代码相关任务。

- DeepSeek-Reasoner: 适合逻辑推理和复杂问题解决。

5.模型选择好后,点击新的聊天,即可正常使用了

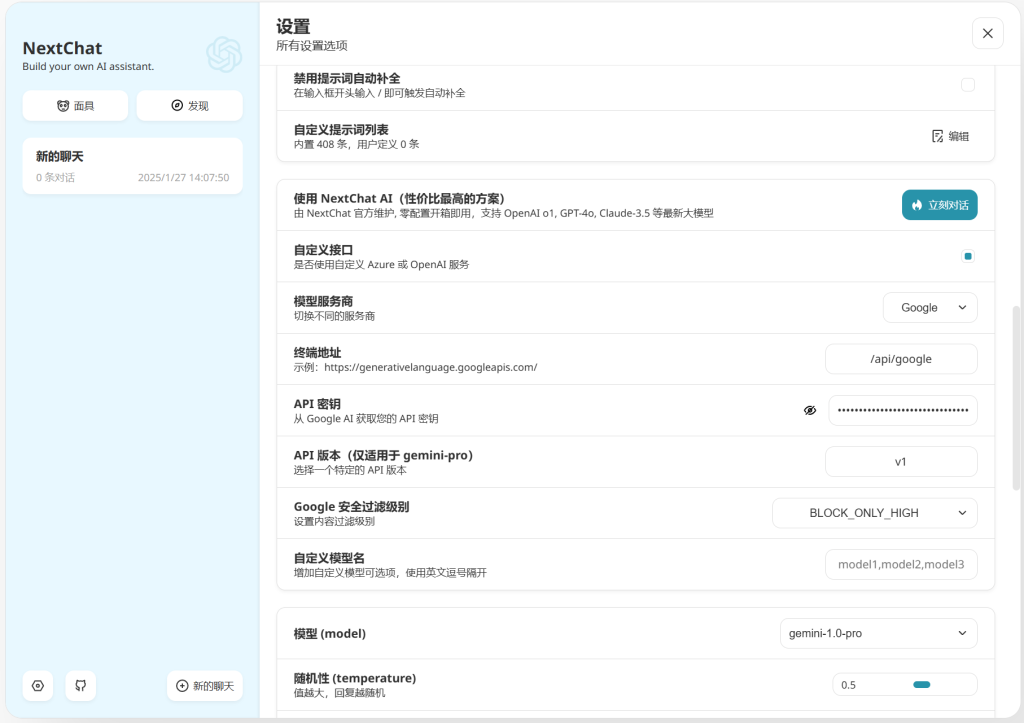

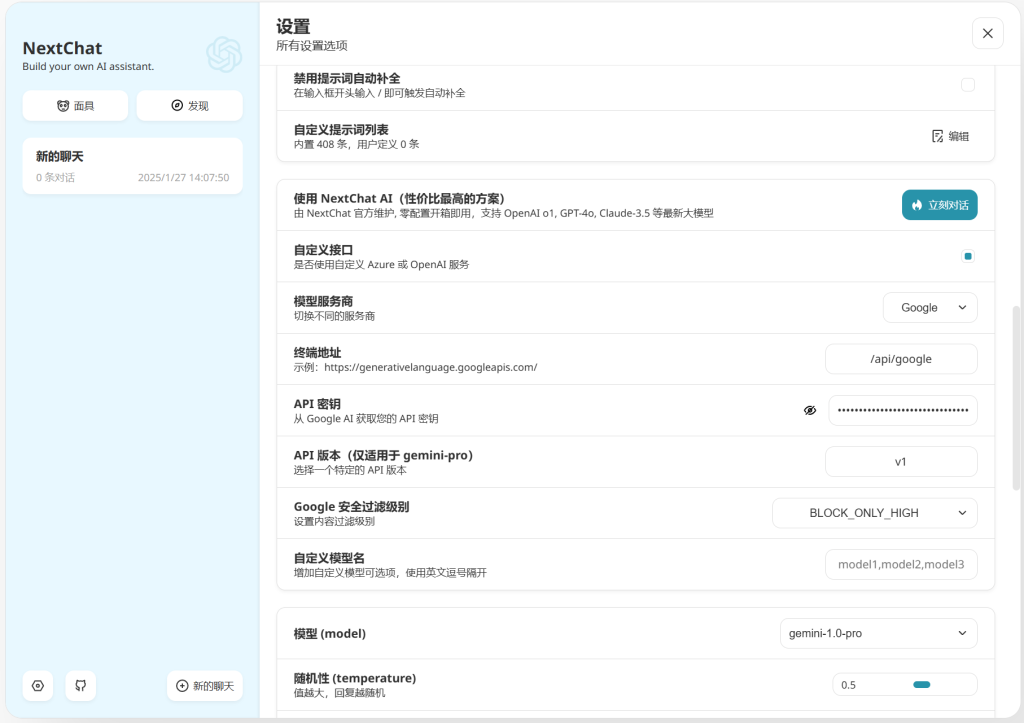

✨四、在老版本ChatGPT-Next-Web内设置deepseek模型

1.访问ChatGPT-Next-Web,点击左下角的设置

2.点击自定义接口

3.自定义模型

API Key:输入之前获取的deepseek api

自定义模型名:deepseek-chat,deepseek-reasoner,deepseek-coder

DeepSeek-V3:适用于通用场景的模型,包括 deepseek-chat 和 deepseek-coder。

DeepSeek-R1:专注于复杂推理任务的新模型,即 deepseek-reasoner。

4.模型选择好后,点击新的聊天,即可正常使用了

🚨 常见问题排查

| 问题现象 | 解决方法 |

|---|---|

| 401 认证失败 | 检查 API Key 有效性 |

| 响应速度慢 | 配置 BASE_URL 使用代理 → 检查服务器网络 |

| 模型不兼容 | 在 DeepSeek 控制台确认可用模型名称 → 修改 DEFAULT_MODEL 配置 |

| 容器启动失败 | 检查端口冲突 → 使用 docker logs chatgpt-web 查看日志 |

⚠️ 重要注意事项

- 计费提醒

DeepSeek API 采用按量计费,建议设置用量监控 - 安全建议

不要使用弱密码!推荐生成复杂密码 openssl rand -base64 16 - 版本更新

# 本地/Docker 部署更新方法:git pull origin main && npm run build

通过本指南,您可在 10 分钟内完成私有化 AI 对话服务的部署。建议首次使用者优先选择 Vercel 部署方案,如需深度定制再采用本地化部署。

Comments 2 条评论

大佬你好我想本地部署一个模型然后放到ChatGPT-Next-Web运行,可是好像不行

@御风而行. ollama+chatgpt-next-web可以的呀。你是不是web访问不到本地的ollama?